微软的27亿参数模型Phi-2展示了出色的推理和语言理解能力,在小于130亿参数的基础语言模型中树立了新的性能标准。

Phi-2在Phi-1和Phi-1.5的基础上进行了改进,通过模型扩展和训练数据筛选的创新,与大25倍的模型相匹配或超越。

Phi-2的紧凑尺寸使其成为研究人员的理想实验场所,有助于在机械解释性、安全性改进和各种任务的微调实验中进行探索。

Phi-2的成就基于两个关键方面:

- 训练数据质量:微软强调训练数据质量在模型性能中的关键作用。Phi-2利用“教科书级别”的数据,专注于设计用于传授常识推理和通识知识的合成数据集。训练语料库还通过精心挑选的网络数据进行增强,根据教育价值和内容质量进行筛选。

- 创新的扩展技术:微软采用创新技术将Phi-2从其前身Phi-1.5扩展。从13亿参数模型中进行的知识转移加速了训练收敛,提高了基准分数。

性能评估

Phi-2在包括Big Bench Hard、常识推理、语言理解、数学和编码等各种基准测试中经过了严格的评估。

仅有27亿参数,Phi-2超越了更大的模型,包括Mistral和Llama-2,并与谷歌最近宣布的Gemini Nano 2相匹配或超越:

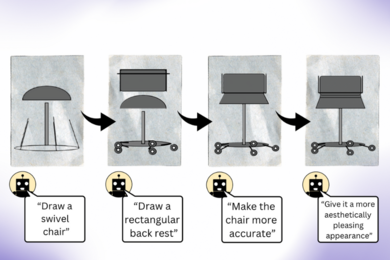

除了基准测试,Phi-2还展示了其在现实场景中的能力。在研究界常用的提示测试中,Phi-2在解决物理问题和纠正学生错误方面展示了其多样性和实用性:

Phi-2是基于Transformer的模型,具有下一个单词预测目标,使用合成和网络数据集的1.4万亿个标记进行训练。训练过程在96个A100 GPU上进行,历时14天,注重保持高水平的安全性,并声称在毒性和偏见方面超过了开源模型。

随着Phi-2的发布,微软继续推动较小基础语言模型的边界。

(图片来源:微软)

另请参阅:AI&Big Data Expo:揭秘AI,看透炒作

想要从行业领导者那里了解更多关于人工智能和大数据的知识吗?请查看在阿姆斯特丹、加利福尼亚和伦敦举办的AI&Big Data Expo。这个综合性的活动与Digital Transformation Week同期举办。

探索由TechForge提供支持的其他即将举行的企业技术活动和网络研讨会这里。