虽然早期的语言模型只能处理文本,但当代的大型语言模型现在可以在不同类型的数据上执行高度多样化的任务。例如,LLM可以理解多种语言,生成计算机代码,解决数学问题,或回答关于图像和音频的问题。

麻省理工学院的研究人员探讨了LLM的内部工作原理,以更好地理解它们如何处理如此多样的数据,并发现它们与人脑有一些相似之处。

神经科学家认为,人脑在前颞叶有一个“语义中心”,它整合来自各种模态的语义信息,如视觉数据和触觉输入。这个语义中心与特定模态的“辐条”相连,这些辐条将信息传递到中心。麻省理工学院的研究人员发现,LLM通过以中心化、概括的方式抽象处理来自不同模态的数据,使用了类似的机制。例如,一个以英语为主的模型会依赖英语作为处理日语输入或推理算术、计算机代码等的中心媒介。此外,研究人员展示了他们可以通过使用模型的主导语言文本干预模型的语义中心,从而改变其输出,即使模型在处理其他语言的数据。

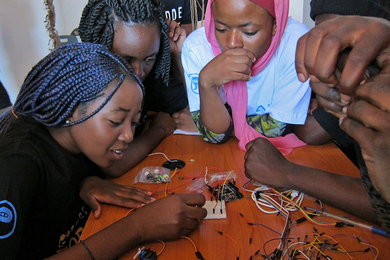

这些发现可能帮助科学家训练未来能够更好地处理多样数据的LLM。

“LLM是巨大的黑箱。它们取得了非常令人印象深刻的表现,但我们对它们的内部工作机制知之甚少。我希望这可以成为更好理解它们工作原理的早期步骤,以便我们能够改进它们,并在需要时更好地控制它们,”电气工程和计算机科学(EECS)研究生、该研究的主要作者Zhaofeng Wu说。

他的合著者包括南加州大学(USC)的研究生Xinyan Velocity Yu;USC的副教授Dani Yogatama;苹果公司的研究科学家Jiasen Lu;以及麻省理工学院EECS的助理教授、计算机科学与人工智能实验室(CSAIL)成员Yoon Kim。该研究将在国际学习表征会议上展示。

整合多样数据

研究人员基于先前的工作,该工作暗示以英语为中心的LLM使用英语在各种语言上进行推理过程。

Wu和他的合作者扩展了这一想法,深入研究LLM处理多样数据的机制。

一个LLM由许多相互连接的层组成,将输入文本分割成称为标记的单词或子词。模型为每个标记分配一个表示,这使其能够探索标记之间的关系并生成序列中的下一个单词。在图像或音频的情况下,这些标记对应于图像的特定区域或音频片段的部分。

研究人员发现,模型的初始层以其特定语言或模态处理数据,类似于人脑中的特定模态辐条。然后,LLM在其内部层中推理时将标记转换为与模态无关的表示,类似于大脑的语义中心如何整合多样信息。

模型为具有相似含义的输入分配相似的表示,尽管它们的数据类型不同,包括图像、音频、计算机代码和算术问题。尽管图像及其文本说明是不同的数据类型,但由于它们共享相同的含义,LLM会为它们分配相似的表示。

例如,一个以英语为主的LLM在生成中文输出之前,会“用英语思考”一个中文文本输入。对于非文本输入,如计算机代码、数学问题,甚至多模态数据,模型也有类似的推理倾向。

为了验证这一假设,研究人员将一对具有相同含义但用两种不同语言书写的句子输入模型。他们测量了模型对每个句子的表示有多相似。

然后,他们进行了第二组实验,将以英语为主的模型输入另一种语言的文本,如中文,并测量其内部表示与英语和中文的相似程度。研究人员对其他数据类型进行了类似的实验。

他们一致发现,对于具有相似含义的句子,模型的表示是相似的。此外,在许多数据类型中,模型在其内部层中处理的标记更像是以英语为中心的标记,而不是输入数据类型。

“许多这些输入数据类型似乎与语言极为不同,因此我们非常惊讶,当模型处理例如数学或编码表达式时,我们能够探测到英语标记,”Wu说。

利用语义中心

研究人员认为,LLM可能在训练过程中学习了这种语义中心策略,因为这是处理多样数据的一种经济方式。

“世界上有成千上万种语言,但许多知识是共享的,比如常识知识或事实知识。模型不需要在不同语言之间重复这些知识,”Wu说。

研究人员还尝试在模型处理其他语言时,使用英语文本干预模型的内部层。他们发现,即使这些输出是其他语言,他们也可以可预测地改变模型的输出。

科学家可以利用这一现象,鼓励模型在多样数据类型之间共享尽可能多的信息,从而提高效率。

但另一方面,可能存在一些概念或知识在语言或数据类型之间无法翻译,例如文化特定知识。在这些情况下,科学家可能希望LLM具有一些特定于语言的处理机制。

“如何在可能的情况下最大限度地共享,同时允许语言具有一些特定于语言的处理机制?这可以在未来的模型架构研究中进行探索,”Wu说。

此外,研究人员可以利用这些见解来改进多语言模型。通常,一个以英语为主的模型在学习说另一种语言时,会失去一些英语的准确性。他表示,更好地理解LLM的语义中心可以帮助研究人员防止这种语言干扰。

“理解语言模型如何跨语言和模态处理输入是人工智能中的一个关键问题。本文与神经科学建立了有趣的联系,并表明所提出的‘语义中心假设’在现代语言模型中成立,其中在模型的中间层中创建了不同数据类型的语义相似表示,”特拉维夫大学计算机科学学院的助理教授Mor Geva Pipek说,他并未参与这项工作。“该假设和实验很好地联系并扩展了先前工作的发现,可能对未来创建更好的多模态模型以及研究它们与人类大脑功能和认知之间的联系产生影响。”

这项研究部分由麻省理工学院-IBM沃森人工智能实验室资助。