在工厂中训练的家庭机器人在用户的厨房中执行家庭任务时,可能无法有效地清洗水槽或倒垃圾,因为这个新环境与其训练空间不同。

为了避免这种情况,工程师们通常会尽量使模拟训练环境与代理将要部署的真实世界相匹配。

然而,来自麻省理工学院及其他地方的研究人员现在发现,尽管这种传统智慧存在,但有时在完全不同的环境中进行训练会产生表现更好的人工智能代理。

他们的研究结果表明,在某些情况下,在一个不确定性较小或“噪声”较少的世界中训练模拟AI代理,使其表现优于在同一噪声世界中训练的竞争AI代理。

研究人员将这一意外现象称为室内训练效应。

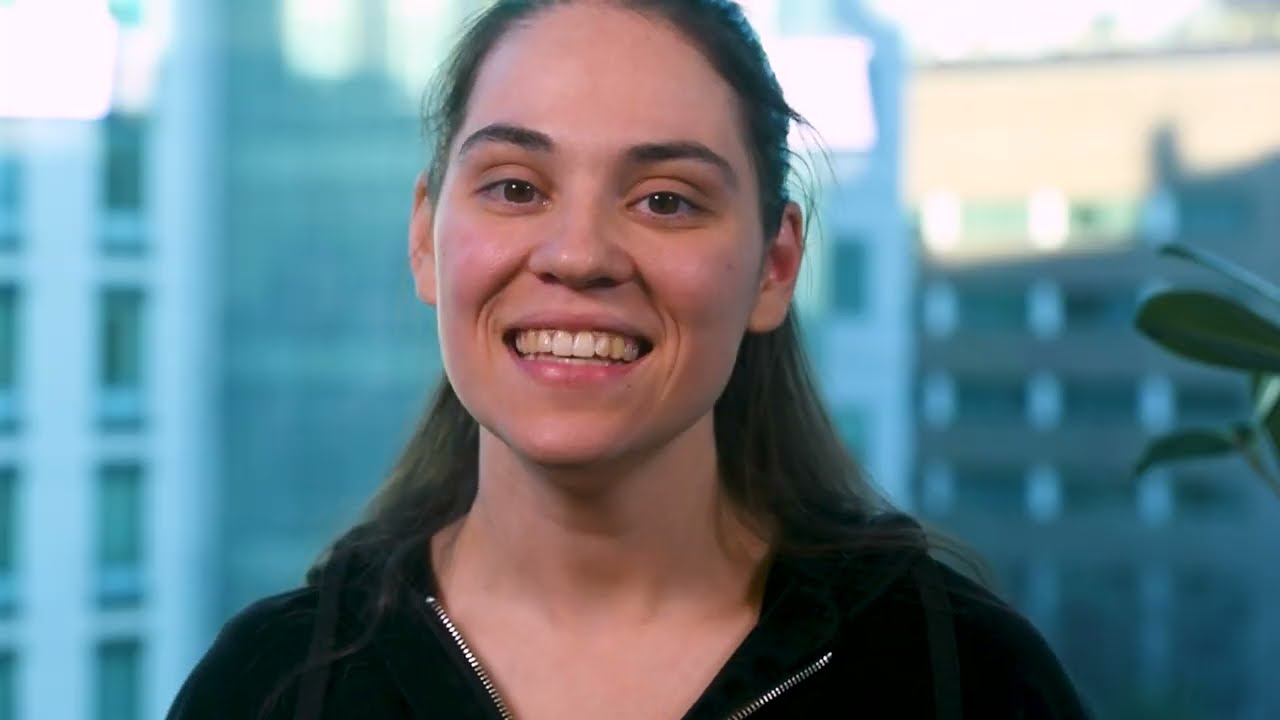

麻省理工学院媒体实验室的研究助理、室内训练效应论文的主要作者Serena Bono解释道:“如果我们在一个没有噪声的室内环境中学习打网球,我们可能更容易掌握不同的击球技巧。然后,如果我们转到一个噪声更大的环境,比如有风的网球场,我们打得好的概率可能会比在有风的环境中学习时更高。”

研究人员通过训练AI代理玩Atari游戏来研究这一现象,他们通过增加一些不可预测性来修改这些游戏。他们惊讶地发现,室内训练效应在不同的Atari游戏和游戏变体中始终存在。

他们希望这些结果能推动更多研究,以开发更好的AI代理训练方法。

合著者、哈佛大学研究生Spandan Madan补充道:“这是一个全新的思考方向。与其试图匹配训练和测试环境,我们可能能够构建模拟环境,让AI代理学习得更好。”

Bono和Madan的论文还包括麻省理工学院研究生Ishaan Grover、耶鲁大学研究生Mao Yasueda、麻省理工学院媒体实验室媒体艺术与科学教授、个人机器人组负责人Cynthia Breazeal、哈佛大学安王计算机科学教授Hanspeter Pfister,以及哈佛医学院教授Gabriel Kreiman。该研究将在人工智能协会会议上展示。

训练问题

研究人员着手探讨为什么强化学习代理在测试与其训练空间不同的环境时表现如此糟糕。

强化学习是一种试错方法,代理在训练空间中探索并学习采取最大化奖励的行动。

团队开发了一种技术,明确地向强化学习问题中的一个元素——转移函数添加一定量的噪声。转移函数定义了代理根据所选择的行动从一个状态转移到另一个状态的概率。

如果代理在玩吃豆人,转移函数可能定义了游戏板上鬼魂向上、向下、向左或向右移动的概率。在标准的强化学习中,AI将使用相同的转移函数进行训练和测试。

研究人员在这种传统方法中向转移函数添加噪声,正如预期的那样,损害了代理在吃豆人游戏中的表现。

但当研究人员用无噪声的吃豆人游戏训练代理,然后在他们向转移函数注入噪声的环境中测试它时,它的表现优于在噪声游戏中训练的代理。

“经验法则是,在训练期间尽可能准确地捕捉部署条件的转移函数,以获得最大的收益。我们真的对此进行了深入测试,因为我们自己都不敢相信,”Madan说。

向转移函数注入不同量的噪声让研究人员测试了许多环境,但并没有创造出真实的游戏。他们向吃豆人注入的噪声越多,鬼魂随机传送到不同方格的可能性就越大。

为了查看室内训练效应是否在正常的吃豆人游戏中发生,他们调整了基础概率,使鬼魂正常移动,但更可能向上和向下移动,而不是向左和向右。在无噪声环境中训练的AI代理在这些真实的游戏中仍然表现更好。

“这不仅仅是因为我们添加噪声的方式来创建临时环境。这似乎是强化学习问题的一个特性。这一点更令人惊讶,”Bono说。

探索解释

当研究人员深入探讨寻找解释时,他们发现AI代理在训练空间中的探索方式存在一些相关性。

当两个AI代理主要探索相同区域时,在无噪声环境中训练的代理表现更好,这可能是因为代理在没有噪声干扰的情况下更容易学习游戏规则。

如果它们的探索模式不同,那么在噪声环境中训练的代理往往表现更好。这可能是因为代理需要理解在无噪声环境中无法学习的模式。

“如果我只在无噪声环境中学习用正手打网球,但在有噪声的环境中我还必须用反手打球,那么我在无噪声环境中的表现就不会那么好,”Bono解释道。

未来,研究人员希望探索室内训练效应如何在更复杂的强化学习环境中发生,或与计算机视觉和自然语言处理等其他技术结合。他们还希望构建旨在利用室内训练效应的训练环境,这可能有助于AI代理在不确定环境中表现得更好。