当声波到达内耳时,那里神经元会捕捉到振动并向大脑发出警报。它们信号中编码了大量信息,使我们能够跟随对话、识别熟悉的声音、欣赏音乐,并迅速找到响铃的电话或哭泣的婴儿。

神经元通过发射脉冲来发送信号——即电压的短暂变化,这些变化沿着神经纤维传播,也称为动作电位。令人惊讶的是,听觉神经元每秒可以发射数百个脉冲,并且能够以极高的精确度将脉冲与进入声波的振荡相匹配。

通过强大的新模型,麻省理工学院麦戈文脑研究所的科学家们确定,这种精确的时机对于我们理解听觉信息的一些最重要方式至关重要,包括识别声音和定位声音。

这些开放获取的研究结果,于12月4日在《自然通讯》期刊上报道,展示了机器学习如何帮助神经科学家理解大脑如何在现实世界中使用听觉信息。领导这项研究的麻省理工学院教授和麦戈文研究员Josh McDermott解释说,他团队的模型更好地装备了研究人员,以研究不同类型听力损失的后果,并设计出更有效的干预措施。

声音的科学

神经系统的听觉信号时机如此精确,研究人员早已怀疑时机对我们感知声音的重要性。声波以决定其音调的速率振荡:低音调的声音以慢波传播,而高音调的声波则更频繁地振荡。将信息从耳朵中的声音探测毛细胞传递到大脑的听神经产生的电脉冲与这些振荡的频率相对应。“听神经中的动作电位在刺激波形的峰值相对的非常特定的时间点被触发,”McDermott解释道,他还是麻省理工学院脑与认知科学系的副主任。

这种关系被称为相位锁定,要求神经元以亚毫秒的精确度来定时其脉冲。但科学家们并不真正知道这些时间模式对大脑有多重要。McDermott表示,除了科学上的吸引力,这个问题还有重要的临床意义:“如果你想设计一个向大脑提供电信号以重现耳朵功能的假体,了解正常耳朵中哪些信息实际上是重要的无疑是相当重要的。”

这在实验上一直很难研究;动物模型无法提供太多关于人类大脑如何提取语言或音乐结构的见解,而听神经在人体中也无法进行研究。因此,McDermott和研究生Mark Saddler博士(2024届)转向了人工神经网络。

人工听觉

神经科学家们长期以来一直使用计算模型来探索大脑如何解码感官信息,但直到最近计算能力和机器学习方法的进步,这些模型仅限于模拟简单任务。“这些先前模型的一个问题是,它们通常表现得太好,”现在在丹麦技术大学的Saddler说。例如,一个被要求识别一对简单音调中较高音调的计算模型,可能比被要求做同样事情的人表现得更好。“这不是我们在听觉中每天都做的任务,”Saddler指出。“大脑并没有优化来解决这个非常人工的任务。”这种不匹配限制了从这一代模型中得出的见解。

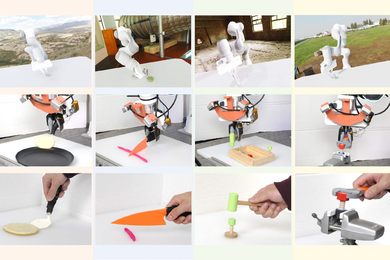

为了更好地理解大脑,Saddler和McDermott希望挑战一个听觉模型,让它执行人们在现实世界中使用听觉的任务,比如识别单词和声音。这意味着开发一个人工神经网络来模拟接收耳朵输入的大脑部分。该网络接收来自约32,000个模拟声音探测感官神经元的输入,然后针对各种现实世界任务进行优化。

研究人员表明,他们的模型很好地复制了人类听觉——比任何先前的听觉行为模型都要好,McDermott说。在一项测试中,人工神经网络被要求在数十种背景噪音中识别单词和声音,从飞机机舱的嗡嗡声到热烈的掌声。在每种条件下,该模型的表现与人类非常相似。

然而,当团队降低模拟耳中脉冲的时机时,他们的模型无法再匹配人类识别声音或确定声音位置的能力。例如,虽然McDermott的团队之前已经表明人们使用音调来帮助识别他人的声音,但模型显示这种能力在没有精确时机信号的情况下会丧失。“你需要相当精确的脉冲时机才能既解释人类行为,又在任务中表现良好,”Saddler说。这表明大脑使用精确时机的听觉信号,因为它们有助于听觉的这些实际方面。

该团队的研究结果展示了人工神经网络如何帮助神经科学家理解耳朵提取的信息如何影响我们对世界的感知,无论是在听力正常还是受损的情况下。“将听觉神经中的放电模式与行为联系起来的能力打开了许多大门,”McDermott说。

“现在我们有了这些将耳朵中的神经反应与听觉行为联系起来的模型,我们可以问,‘如果我们模拟不同类型的听力损失,这将对我们的听觉能力产生什么影响?’”McDermott说。“这将帮助我们更好地诊断听力损失,我们认为这也可以扩展到帮助我们设计更好的助听器或人工耳蜗。”例如,他说,“人工耳蜗在各方面都有局限——它可以做一些事情而不能做其他事情。如何设置这个人工耳蜗以使你能够调节行为?原则上,你可以使用这些模型来告诉你这一点。”