如果有人建议你“了解自己的极限”,他们很可能是在建议你适度锻炼。然而,对于机器人来说,这个座右铭代表的是学习约束,或者说是在机器环境中执行特定任务的限制,以安全和正确地完成家务。

例如,想象一下让一台机器人清理你的厨房,但它并不理解周围环境的物理特性。机器如何生成一个实用的多步骤计划,以确保房间一尘不染?大型语言模型(LLMs)可以让它们接近,但如果模型仅仅是在文本上进行训练,它很可能会错过关于机器人物理限制的关键细节,比如它能伸多远,或者是否有需要避免的障碍物。仅依赖LLMs,你可能最终会在地板上清理意大利面酱的污渍。

为了指导机器人执行这些开放式任务,麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究人员使用视觉模型来观察机器附近的环境并建模其约束。该团队的策略涉及一个LLM绘制一个计划,并在模拟器中检查以确保其安全和现实。如果该行动序列不可行,语言模型将生成一个新计划,直到找到一个机器人可以执行的计划。

这种试错方法,研究人员称之为“通过代码进行连续约束满足的机器人规划”(PRoC3S),测试长远计划以确保它们满足所有约束,并使机器人能够执行诸如写信、画星星以及将积木分类和放置在不同位置等多样化任务。未来,PRoC3S可能帮助机器人在动态环境中完成更复杂的家务,比如在家中,它们可能会被要求执行一个由多个步骤组成的常规任务(例如“给我做早餐”)。

“LLMs和经典的机器人系统,如任务和运动规划器,无法单独执行这些任务,但它们的协同作用使得开放式问题解决成为可能,”博士生Nishanth Kumar SM ’24说,他是关于PRoC3S新论文的共同第一作者。“我们正在实时创建机器人周围环境的模拟,并尝试许多可能的行动计划。视觉模型帮助我们创建一个非常现实的数字世界,使机器人能够推理出长远计划每一步的可行行动。”

该团队的工作在上个月的德国慕尼黑机器人学习会议(CoRL)上发表。

研究人员的方法使用了一个在互联网上的文本上预训练的LLM。在要求PRoC3S执行任务之前,团队为他们的语言模型提供了一个与目标任务(绘制星星)相关的示例任务(如绘制正方形)。示例任务包括活动的描述、长远计划以及关于机器人环境的相关细节。

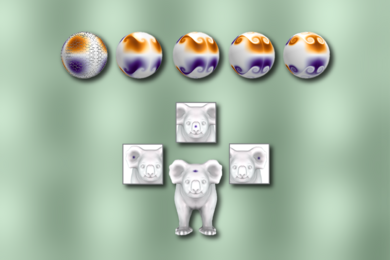

但这些计划在实践中表现如何?在模拟中,PRoC3S成功地绘制了星星和字母,每种情况的成功率为80%。它还能够将数字积木堆叠成金字塔和直线,并准确地放置物品,比如将水果放在盘子上。在这些数字演示中,CSAIL的方法完成请求的任务的成功率比类似的方法,如“LLM3”和“代码作为策略”更高。

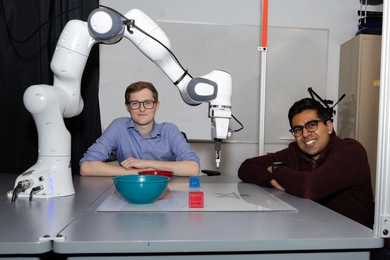

接下来,CSAIL的工程师将他们的方法带入现实世界。他们的方法在机器人手臂上开发并执行计划,教它将积木放成直线。PRoC3S还使机器能够将蓝色和红色积木放入匹配的碗中,并将所有物体移动到桌子中心附近。

Kumar和共同第一作者Aidan Curtis SM ’23(他也是CSAIL的博士生)表示,这些发现表明,LLM可以制定出人类可以信任的更安全的计划。研究人员设想一种家庭机器人,可以接受更一般的请求(如“给我拿些薯片”),并可靠地找出执行所需的具体步骤。PRoC3S可以帮助机器人在相同的数字环境中测试计划,以找到可行的行动方案——更重要的是,给你带来美味的小吃。

在未来的工作中,研究人员旨在使用更先进的物理模拟器来改善结果,并通过更可扩展的数据搜索技术扩展到更复杂的长远任务。此外,他们计划将PRoC3S应用于移动机器人,例如四足机器人,以执行包括行走和扫描周围环境的任务。

“使用像ChatGPT这样的基础模型来控制机器人动作可能会导致由于幻觉而产生不安全或不正确的行为,”AI研究所的研究员Eric Rosen说,他并未参与该研究。“PRoC3S通过利用基础模型进行高层次任务指导,同时采用明确推理世界的AI技术,以确保可验证的安全和正确的行动,解决了这个问题。这种基于规划和数据驱动的方法的结合可能是开发能够理解并可靠执行比目前可能的更广泛任务的机器人的关键。”

Kumar和Curtis的共同作者也是CSAIL的成员:麻省理工学院本科生研究员Jing Cao和麻省理工学院电气工程与计算机科学系的教授Leslie Pack Kaelbling和Tomás Lozano-Pérez。他们的工作部分得到了国家科学基金会、空军科学研究办公室、海军研究办公室、陆军研究办公室、麻省理工学院智能探索计划和AI研究所的支持。