如果让像GPT-4这样的大型语言模型(LLM)去嗅闻一个被雨水浸湿的露营地,它会礼貌地拒绝。如果让同样的系统来描述那种气味,它会用“充满期待的空气”和“既清新又泥土气息的香味”来诗意地表达,尽管它既没有经历过雨,也没有鼻子来帮助它做出这样的观察。对此现象的一种可能解释是,LLM只是模仿其庞大训练数据中的文本,而并非真正理解雨或气味。

但缺乏眼睛是否意味着语言模型永远无法“理解”狮子比家猫“更大”?哲学家和科学家们长期以来一直认为,赋予语言意义的能力是人类智慧的标志——并思考使我们能够做到这一点的基本成分。

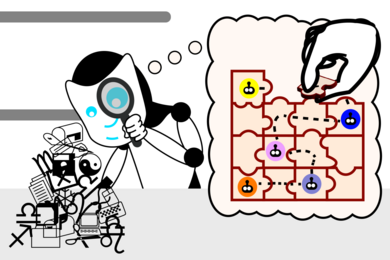

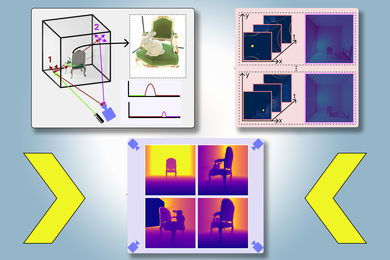

深入探讨这一谜团,麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究人员发现了一些有趣的结果,表明语言模型可能会发展出自己的现实理解,以提高其生成能力。研究小组首先开发了一组小型Karel难题,内容是提出指令以控制机器人在模拟环境中的移动。然后,他们在解决方案上训练了一个LLM,但没有展示解决方案是如何实际工作的。最后,使用一种称为“探测”的机器学习技术,他们观察了模型在生成新解决方案时的“思维过程”。

在对超过100万个随机难题进行训练后,他们发现模型自发地发展出了对基础模拟的理解,尽管在训练期间从未接触过这种现实。这些发现质疑了我们对学习语言意义所需信息类型的直觉——以及LLM是否有一天可能在更深层次上理解语言。

“在这些实验开始时,语言模型生成的随机指令是无效的。到我们完成训练时,我们的语言模型生成正确指令的比例达到了92.4%,”麻省理工学院电气工程与计算机科学(EECS)博士生、CSAIL成员查尔斯·金(Charles Jin)说,他是这项新论文的主要作者。“这对我们来说是一个非常激动的时刻,因为我们认为,如果你的语言模型能够以这样的准确性完成任务,我们可能会期望它也理解语言中的意义。这为我们探索LLM是否真的理解文本提供了一个起点,现在我们看到它们的能力远不止于盲目地拼凑单词。”

在LLM的思维中

探测帮助金亲眼见证了这一进展。它的角色是解释LLM认为指令的含义,揭示LLM发展出了自己内部的模拟,展示机器人如何响应每个指令。随着模型解决难题的能力提高,这些概念也变得更加准确,表明LLM开始理解指令。不久之后,模型就能持续正确地将各个部分组合在一起,形成有效的指令。

金指出,LLM对语言的理解是分阶段发展的,就像孩子学习语言的多个步骤一样。起初,它就像一个婴儿在咿呀学语:重复且大多无法理解。然后,语言模型获得了语法,即语言的规则。这使它能够生成看起来像真正解决方案的指令,但这些指令仍然无效。

不过,LLM的指令逐渐改善。一旦模型获得了意义,它开始生成正确实现请求规范的指令,就像孩子形成连贯的句子一样。

将方法与模型分开:“反常世界”

探测的初衷只是“进入LLM的大脑”,正如金所描述的,但也有可能它为模型进行了一些思考。研究人员希望确保他们的模型独立于探测理解指令,而不是探测从LLM对语法的理解中推断机器人的运动。

“想象一下你有一堆数据,编码了LM的思维过程,”金建议道。“探测就像一个法医分析师:你把这堆数据交给分析师,并说,‘这是机器人如何移动的,现在试着在这堆数据中找到机器人的运动。’分析师后来告诉你,他们知道在这堆数据中机器人发生了什么。但如果这堆数据实际上只是编码了原始指令,而分析师找到了某种巧妙的方法来提取指令并相应地遵循它们呢?那么语言模型实际上并没有真正理解指令的含义。”

为了理清它们的角色,研究人员翻转了新探测的指令含义。在金所称的“反常世界”中,像“上”这样的指令现在在移动机器人时意味着“下”。

“如果探测正在将指令翻译为机器人位置,它应该能够根据反常含义同样好地翻译指令,”金说。“但如果探测实际上是在语言模型的思维过程中找到原始机器人运动的编码,那么它应该在从原始思维过程中提取反常机器人运动时遇到困难。”

结果,新探测经历了翻译错误,无法解释具有不同指令含义的语言模型。这意味着原始语义嵌入在语言模型中,表明LLM独立于原始探测分类器理解所需的指令。

“这项研究直接针对现代人工智能中的一个核心问题:大型语言模型的惊人能力是否仅仅归因于大规模的统计相关性,还是大型语言模型发展出对它们被要求处理的现实的有意义理解?这项研究表明,LLM发展出对模拟现实的内部模型,尽管它从未被训练去发展这个模型,”麻省理工学院EECS教授、CSAIL成员及论文的资深作者马丁·林纳德(Martin Rinard)说。

这项实验进一步支持了团队的分析,即语言模型可以发展出对语言的更深理解。不过,金承认他们的论文有一些局限性:他们使用了一种非常简单的编程语言和相对较小的模型来获取他们的见解。在一项即将发布的工作中,他们将寻求使用更通用的设置。虽然金的最新研究没有概述如何让语言模型更快地学习意义,但他相信未来的工作可以在这些见解的基础上改进语言模型的训练方式。

“一个引人入胜的开放问题是,LLM是否实际上在使用其内部现实模型来推理该现实,因为它解决机器人导航问题,”林纳德说。“虽然我们的结果与LLM以这种方式使用模型是一致的,但我们的实验并未设计来回答下一个问题。”

“如今关于LLM是否真的在‘理解’语言,或者它们的成功是否可以归因于本质上来自大量文本的技巧和启发式方法的争论很多,”布朗大学计算机科学与语言学助理教授艾莉·帕夫利克(Ellie Pavlick)说,她并未参与这篇论文。“这些问题处于我们构建人工智能的核心,以及我们期望技术的固有可能性或局限性。这是一篇很好的论文,以一种受控的方式探讨这个问题——作者利用计算机代码与自然语言一样具有语法和语义的事实,但与自然语言不同的是,语义可以直接观察和操控以进行实验。实验设计优雅,研究结果乐观,表明也许LLM可以更深入地学习语言‘意味着什么’。”

金和林纳德的论文部分得到了美国国防高级研究计划局(DARPA)的资助。