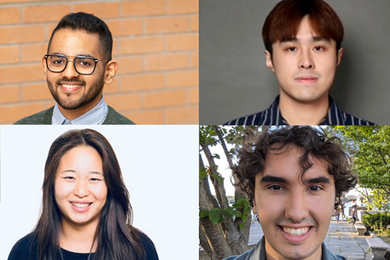

为了使自然语言成为一种有效的沟通形式,参与的各方需要能够理解单词及其上下文,假设内容在很大程度上是以善意和可信赖的方式共享的,对所分享的信息进行推理,并将其应用于现实场景。麻省理工学院的博士生在麻省理工学院-IBM沃森人工智能实验室实习的学生 – Athul Paul Jacob SM ’22,Maohao Shen SM ’23,Victor Butoi和Andi Peng SM ’23 – 正在攻击自然语言模型中嵌入的每个步骤,以使AI系统对用户更可靠和准确。

为了实现这一目标,Jacob的研究从博弈论的角度着手改进现有的自然语言模型的输出。他说,他的兴趣有两个方面:“一个是通过多智能体系统和语言理解的视角来理解人类行为,另一个是‘如何将其作为洞察力来构建更好的AI系统?’”他的工作源于棋盘游戏“外交”,他的研究团队开发了一个能够学习和预测人类行为并进行战略谈判以实现期望的最佳结果的系统。

Jacob说:“这是一个需要建立信任的游戏;你需要使用语言进行沟通。你还需要同时与其他六个玩家对战,这与过去人们处理的所有任务领域都非常不同。”他指的是研究人员将扑克和围棋等其他游戏放入神经网络中的情况。Jacob和他的研究导师 – 包括麻省理工学院电气工程和计算机科学系(EECS)的副教授Jacob Andreas和助理教授Gabriele Farina,以及麻省理工学院-IBM沃森人工智能实验室的Yikang Shen – 将语言生成问题重新构建为一个双人游戏。

Jacob的团队使用“生成器”和“鉴别器”模型开发了一个自然语言系统,用于回答问题,然后观察答案并确定其是否正确。如果正确,AI系统将获得一分;如果不正确,则不会获得分数。众所周知,语言模型往往会产生幻觉,使其不太可靠;这种无悔学习算法协同地采用自然语言模型,并鼓励系统的答案更加真实可靠,同时保持解决方案接近预先训练的语言模型的先验知识。Jacob表示,使用这种技术与较小的语言模型结合使用,很可能使其在性能上与多次更大的模型相媲美。

一旦语言模型生成结果,研究人员理想情况下希望其生成的结果的自信程度与准确性相一致,但这经常不是这样。当模型应该低自信度时,可能会出现模型报告高自信度的幻觉。Maohao Shen及其小组与导师Gregory Wornell(EECS的Sumitomo教授)以及IBM研究员Subhro Das,Prasanna Sattigeri和Soumya Ghosh一起,通过不确定性量化(UQ)来解决这个问题。Shen说:“我们的项目旨在在语言模型校准不良时校准它们。”具体而言,他们正在研究分类问题。为此,Shen允许语言模型生成自由文本,然后将其转换为多项选择分类任务。例如,他们可能会要求模型解决一个数学问题,然后询问它生成的答案是否正确,如“是,否或可能”。这有助于确定模型是否过于自信或自信不足。

团队开发了一种技术,可以调整预训练语言模型的自信输出。研究人员使用基准数据训练了一个辅助模型,以便他们的系统能够纠正语言模型。“如果你的模型对其预测过于自信,我们能够检测到并使其自信度降低,反之亦然,”Shen解释道。团队在多个流行的基准数据集上评估了他们的技术,以展示其在未见任务上的泛化能力,以重新调整语言模型预测的准确性和自信度。“训练后,您只需将此技术插入并应用于新任务,无需任何其他监督,”Shen说。“您唯一需要的是该新任务的数据。”

Victor Butoi还增强了模型的能力,但他的实验室团队 – 包括EECS的Dugald C. Jackson计算机科学和电气工程教授John Guttag,IBM研究员Leonid Karlinsky和Rogerio Feris,以及鲍恩大学的Hilde Kühne和格拉茨科技大学的Wei Lin – 正在创建技术,以使视觉语言模型能够推理它们所看到的内容,并设计提示来解锁新的学习能力和理解关键短语。

Butoi解释说,组合推理只是我们要求机器学习模型在现实世界情况下执行的决策过程的另一个方面。“您需要能够以组合方式思考问题并解决子任务,”Butoi说,“例如,如果您说椅子在人的左边,您需要同时识别椅子和人。您需要理解方向。”然后,一旦模型理解了“左边”,研究团队希望模型能够回答涉及“左边”的其他问题。

Butoi解释说,令人惊讶的是,视觉语言模型在组合推理方面表现不佳,但是可以通过一个可以“引导证人”的模型来帮助它们。该团队开发了一个使用称为大型语言模型的低秩适应(LoRA)技术进行调整的模型,并在一个名为Visual Genome的带有图像对象和表示关系(如方向)的注释数据集上进行训练。在这种情况下,训练过的LoRA模型将被引导以描述与“左边”关系有关的内容,然后将此标题输出用于提供上下文并提示视觉语言模型,使其成为“明显更容易的任务”,Butoi说。

在机器人领域,AI系统还使用计算机视觉和语言与其周围环境进行交互。环境可能从仓库到家庭不等。Andi Peng和导师麻省理工学院航空航天学教授Julie Shah和实验室和马萨诸塞大学阿默斯特分校的Chuang Gan专注于使用虚拟世界来帮助有身体限制的人。为此,Peng的团队正在开发两个具体化的AI模型 – 一个需要支持的“人类”和一个助手代理 – 在一个名为ThreeDWorld的模拟环境中。团队专注于人类/机器人交互,利用大型语言模型捕获的语义先验知识来帮助助手AI推断“人类”代理可能无法完成的任务以及“人类”行为背后的动机,使用自然语言。团队希望加强助手的顺序决策、双向交流、理解物理场景的能力以及最佳贡献方式。

Peng说:“很多人认为AI程序应该是自主的,但我认为过程的一个重要部分是我们为人类构建机器人和系统,我们希望传达人类的知识。”Peng说:“我们不希望系统以奇怪的方式做事情;我们希望它们以我们可以理解的人类方式来做事情。”