想象一下,当你在手机上滚动照片时,突然看到一张你一开始无法辨认的图片。它看起来像沙发上的一团模糊的东西;可能是一个枕头还是一件外套?几秒钟后,你恍然大悟——当然!那团毛绒绒的东西是你朋友的猫,摩卡。虽然你的一些照片可能一眼就能理解,但为什么这张猫的照片要困难得多呢?

麻省理工学院计算机科学与人工智能实验室(CSAIL)的研究人员惊讶地发现,尽管在从医疗保健到交通运输再到家庭设备等关键领域中,理解视觉数据的重要性不言而喻,但人类对于图像识别的困难程度几乎完全被忽视。基于深度学习的人工智能取得进展的主要驱动因素之一是数据集,然而我们对于大规模深度学习中数据如何推动进展的了解甚少,除了更大就是更好。

在需要理解视觉数据的实际应用中,尽管模型在当前数据集上表现良好,包括那些明确设计用于挑战具有去偏差图像或分布变化的机器的数据集,但人类的表现仍然超过了目标识别模型。这个问题部分原因在于我们对于图像或数据集的绝对难度没有指导。如果在评估中不控制用于评估的图像的难度,很难客观地评估达到人类水平性能的进展,涵盖人类能力范围,并增加数据集的挑战。

为了填补这一知识空白,麻省理工学院电气工程和计算机科学博士生、CSAIL成员大卫·梅奥(David Mayo)深入研究了图像数据集的世界,探索了为什么某些图像对人类和机器的识别比其他图像更困难。梅奥是这项工作的主要作者之一,他说:“有些图像本质上需要更长的时间才能识别,了解大脑在这个过程中的活动及其与机器学习模型的关系至关重要。也许在我们当前的模型中缺少复杂的神经回路或独特的机制,只有在面对具有挑战性的视觉刺激时才能看到。这种探索对于理解和提升机器视觉模型至关重要。”

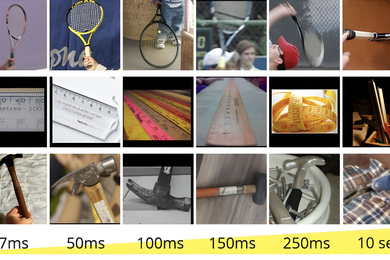

这导致了一个新的度量标准的开发,即“最小观看时间”(MVT),它根据一个人在正确识别之前需要观看图像的时间来量化图像的难度。使用ImageNet的一个子集(机器学习中的一个流行数据集)和ObjectNet(一个旨在测试对象识别鲁棒性的数据集),研究团队向参与者展示了不同持续时间的图像,从短至17毫秒到长达10秒,并要求他们从50个选项中选择正确的对象。经过20多万次图像呈现试验,团队发现现有的测试集,包括ObjectNet,在MVT较短的图像上似乎偏向于更容易的图像,绝大多数基准性能来自于对人类来说容易的图像。

该项目在模型性能方面确定了有趣的趋势,特别是与规模相关的趋势。较大的模型在更简单的图像上显示出显著改进,但在更具挑战性的图像上进展较小。结合语言和视觉的CLIP模型在朝着更接近人类识别的方向上表现出色。

梅奥说:“传统上,对象识别数据集偏向于较简单的图像,这种做法导致了模型性能指标的膨胀,这些指标并不真正反映模型的鲁棒性或其处理复杂视觉任务的能力。我们的研究揭示了更难的图像提出了更严峻的挑战,导致了常规评估中经常没有考虑到的分布偏移。”他还说:“我们发布了按难度标记的图像集,以及自动计算MVT的工具,使MVT能够添加到现有的基准测试中,并扩展到各种应用。这些应用包括在部署现实世界系统之前测量测试集的难度,发现图像难度的神经相关性,以及推进对象识别技术以缩小基准和实际性能之间的差距。”

麻省理工学院电气工程和计算机科学研究生杰西·卡明斯(Jesse Cummings)是该论文的共同第一作者,他与梅奥一起撰写了该论文。他说:“我最大的收获之一是,我们现在有了另一个维度来评估模型。我们希望模型能够识别任何图像,即使——也许尤其是——对人类来说很难识别。我们是第一个量化这意味着什么的人。我们的结果表明,尽管当今的最先进技术还没有达到这一点,但我们当前的评估方法也无法告诉我们何时达到这一点,因为标准数据集过于偏向于简单的图像。”

从ObjectNet到MVT

几年前,这个项目的团队在机器学习领域发现了一个重大挑战:模型在分布不同的图像上表现不佳,或者说这些图像在训练数据中没有很好地表示。于是他们创建了ObjectNet,这是一个由从现实生活中收集的图像组成的数据集。该数据集通过消除其他基准测试中存在的虚假相关性(例如对象与其背景之间的关系)来揭示机器学习模型与人类识别能力之间的性能差距。ObjectNet揭示了机器视觉模型在数据集和实际应用中的性能差距,鼓励许多研究人员和开发人员使用该数据集,从而改善了模型的性能。

现在,团队通过MVT进一步推进了他们的研究。与传统方法专注于绝对性能不同,这种新方法通过对比模型对最简单和最困难的图像的响应来评估模型的表现。该研究进一步探讨了图像难度如何解释,并测试其与人类视觉处理的相似性。通过使用c-score、预测深度和对抗鲁棒性等指标,研究团队发现网络对于更难的图像的处理方式不同。“虽然有一些可观察到的趋势,比如更容易的图像更具典型性,但对图像难度的全面语义解释仍然困扰着科学界,”梅奥说。

例如,在医疗保健领域,理解视觉复杂性的相关性变得更加明显。人工智能模型解释医学图像(如X射线)的能力取决于图像的多样性和难度分布。研究人员主张对专业人士进行难度分布的细致分析,确保基于专业标准而不是普通人的解释对AI系统进行评估。

梅奥和卡明斯目前还在研究视觉识别的神经基础,探究大脑在处理简单和具有挑战性图像时是否表现出不同的活动。该研究旨在揭示复杂图像是否会招募与视觉处理通常不相关的额外脑区,帮助解开我们的大脑如何准确高效地解码视觉世界的谜团。

朝着人类水平的性能

展望未来,研究人员不仅致力于探索提高人工智能对图像难度的预测能力的方法,还在努力找出与观看时间难度的相关性,以生成更难或更容易的图像版本。

尽管这项研究取得了重大进展,但研究人员也承认了一些限制,特别是在将对象识别与视觉搜索任务分离方面。当前的方法确实集中于识别对象,忽略了杂乱图像引入的复杂性。

约翰霍普金斯大学认知科学和计算机科学杰出教授、布隆伯格杰出教授艾伦·L·尤尔(Alan L. Yuille)评论说:“这是一项关于如何利用人类感知来识别AI视觉模型通常被基准测试中高估的弱点的研究,这些基准测试集中于简单的图像。这将有助于制定更现实的基准测试,不仅改进了AI,还使AI与人类感知之间进行了更公平的比较。”

Anthropic技术人员、麻省理工学院博士生西蒙·科恩布利斯(Simon Kornblith)评论说:“广泛认为计算机视觉系统现在的表现优于人类,在一些基准数据集上确实如此。然而,这些基准测试的困难很大程度上来自于图像中的内容的晦涩性;普通人对于不同品种的狗了解得不够多。相比之下,这项工作侧重于人们只有在给予足够时间的情况下才能正确识别的图像。这些图像对于计算机视觉系统来说通常更难,但最好的系统只比人类差一点点。”

梅奥、卡明斯和林新宇(Xinyu Lin)与CSAIL研究科学家安德烈·巴尔布(Andrei Barbu)、CSAIL首席研究科学家鲍里斯·卡茨(Boris Katz)和麻省理工学院-IBM沃森人工智能实验室首席研究员丹·古特弗伦德(Dan Gutfreund)一起撰写了这篇论文。这些研究人员是麻省理工学院大脑、思维和机器中心的成员。

该团队将在2023年神经信息处理系统会议(NeurIPS)上展示他们的工作。